Buongiorno,

Ho problemi con la sitemap del mio sito.

sitemap: https://www.wdracing.eu/it/module/lgsitemaps/sitemap?fc=module&name=sitemap_1

In sostanza Google mi segnala che alcuni link sono bloccati dal file robot.txt

esempio link: https://www.wdracing.eu/it/pastiglie-e-pinze-freno/25646-distanziale-braking-honda-crf-19-270mm.html

nostro file robot.txt: https://www.wdracing.eu/robots.txt

Quando però analizzo il link con l'apposito tool di Googlebot, non vengono trovati errori o avvisi ed il link risulta consentito.

Cosa mi consigliate di fare per risolvere il problema ?

Aggiungo inoltre che diverse pagine risultano escluse. in totale ho:

23691 pagine valide

4200 con errori

8024 escluse di cui 5200 scansionata ma non indiicizzata ed il resto rilevata ma non indicizzata

Inoltre che pochissime delle immagini prodotto compaiono in google immagini.

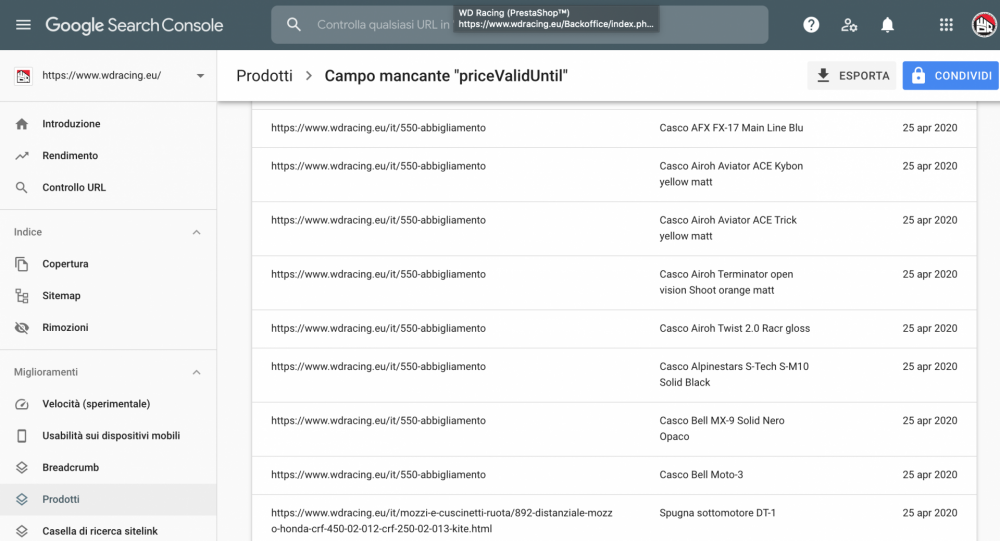

Se dalla search console vado in miglioramenti--> prodotti--> campo mancante description, brand ed altri, vedo 0 pagine valide e 20000 con avvisi. Se scorro tra queste pagine vedo link di categorie o di marche e non dei singoli prodotti mentre il nome elemento è quello del prodotto è normale ? allego immagine sotto

in merito a quest ultimo problema ne parlano anche qui: https://support.google.com/webmasters/thread/7159245?hl=en

se analizzo un link prodotto con lo strumento di analisi dati strutturati come mai mi compaiono anche altri prodotti ?

Mi potete gentilmente aiutare ?